借助对话式 AI 部署服务似乎比较困难,但 NVIDIA 现已具备能够简化这一流程的工具,包括一项名为 NVIDIA Riva 的新技术。

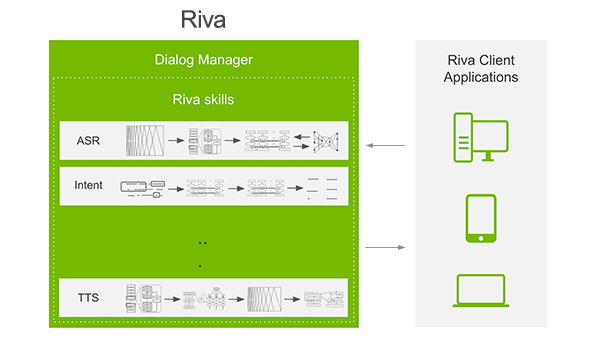

NVIDIA Riva 是一种使用 GPU 加速的应用程序框架,允许公司使用视频和语音数据,为自己的行业、产品和客户定制先进的对话式 AI 服务。

该框架为对话式 AI 提供了端到端的深度学习流程。它包含先进的深度学习模型,例如用于自然语言理解的 NVIDIA Megatron BERT。企业可以利用 NVIDIA NeMo 进一步在数据上调优这些模型,利用 NVIDIA® TensorRT™ 优化推理,并使用 NVIDIA GPU Cloud™ (NGC) 上的 Helm 图表(NVIDIA 的 GPU 优化软件目录)在云端和本地部署。

使用 Riva 构建的应用程序可以利用新款 NVIDIA A100 Tensor Core GPU 中的创新技术进行 AI 计算,并利用 NVIDIA TensorRT 的新型优化技术进行推理。这使得使用功能强大的视觉和语音模型能够运行整个多模态应用程序,并且速度比实时交互的 300 毫秒阈值还要快。

Riva 用例

世界各地的公司正在使用 NVIDIA 对话式 AI 平台来改善其服务。

东芝 (Toshiba)、AT&T 和其他先进的公司都在使用 Voca 的 AI 虚拟代理 –利用 NVIDIA 进行更快、更具交互性以及类似人类的互动。Voca 利用 AI 来理解客户的对话和语音的全部意图。这使得智能体可以自动识别不同的音调和声音线索,从而区分客户说的话以及客户话里的含义。此外,他们还可以利用 NVIDIA AI 平台内置的可扩展性功能来大大缩短客户的等待时间。

Kensho 位于马萨诸塞州剑桥市 S&P Global 创新中心,它部署了可扩展的机器学习和分析系统。Kensho 使用 NVIDIA 的对话式 AI 开发了 Scribe,这是一种用于金融和商业的语音识别解决方案。借助 NVIDIA,Scribe 在盈利电话会议和类似的财务音频方面的准确度比其他商业解决方案高出高达 20%。

Square 创建了一个 AI 虚拟助理,允许 Square 卖家使用 AI 自动确认、取消或更改与客户的约会。这使他们能够开展更具战略性的客户互动。借助 GPU,Square 能够以比 CPU 快 10 倍的速度训练模型,从而提供更准确、更像人类一样的互动。