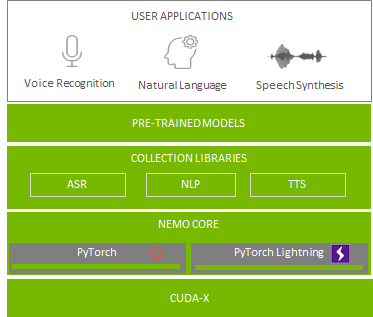

借助对话式 AI 部署服务似乎比较困难,但 NVIDIA 现已具备能够简化这一流程的工具,包括神经模块(简称 NeMo)和一项名为 NVIDIA Riva 的新技术。为节省时间,NGC 软件中心还提供预训练 ASR 模型、训练脚本和性能结果。

NVIDIA NeMo 是一款基于 PyTorch 创建的工具包,能够开发用于对话式 AI 的 AI 应用程序。在模块化深度神经网络的开发过程中,NeMo 可通过连接模组、混合和匹配组件来实现快速实验。NeMo 模块通常表示数据层、编码器、解码器、语言模型、损失函数或组合激活函数的方法。NeMo 针对 ASR、NLP 和 TTS 使用可重复使用的组件,使得构建复杂神经网络架构和系统变得容易。此外,借助 NVIDIA GPU Cloud (NGC),您可以获得用于对话式 AI 的 NeMo 资源,例如预训练模型、用于训练或评估的脚本,以及 NeMo 端到端应用程序,允许开发者试验不同算法并使用各自数据集执行迁移学习。

为促进整个 ASR 流程的实施和领域适应性,NVIDIA 创建了特定于域的 NeMo ASR 应用程序。此应用程序由 NeMo 助力开发,支持您使用自己的数据来训练或微调预训练(声音和语言)ASR 模型。您可以借此逐步创建专为您自己的数据而构建的更高性能 ASR 模型。

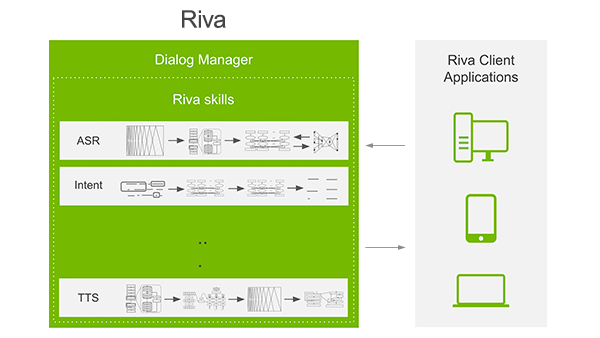

NVIDIA Riva 是一款应用程序框架,能够为完成对话式 AI 任务提供多个制流程。

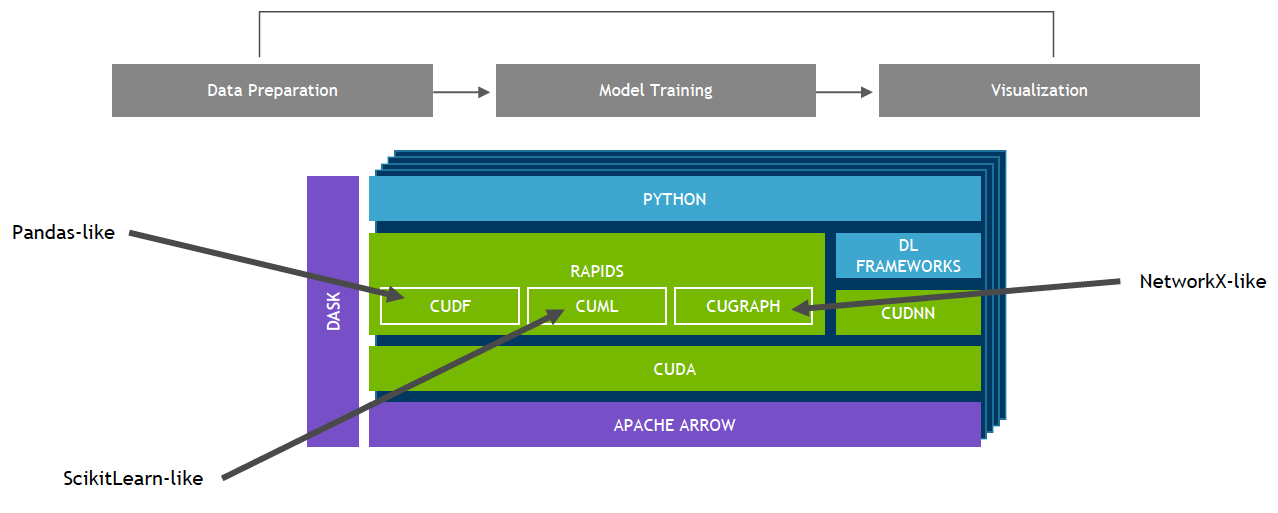

NVIDIA GPU 加速的端到端数据科学

建立在 CUDA 基础上的 NVIDIA RAPIDS™ 开源软件库套件使您能够完全在 GPU 上执行端到端数据科学和分析流程,同时仍然使用 Pandas 和 Scikit-Learn API 等熟悉的界面。

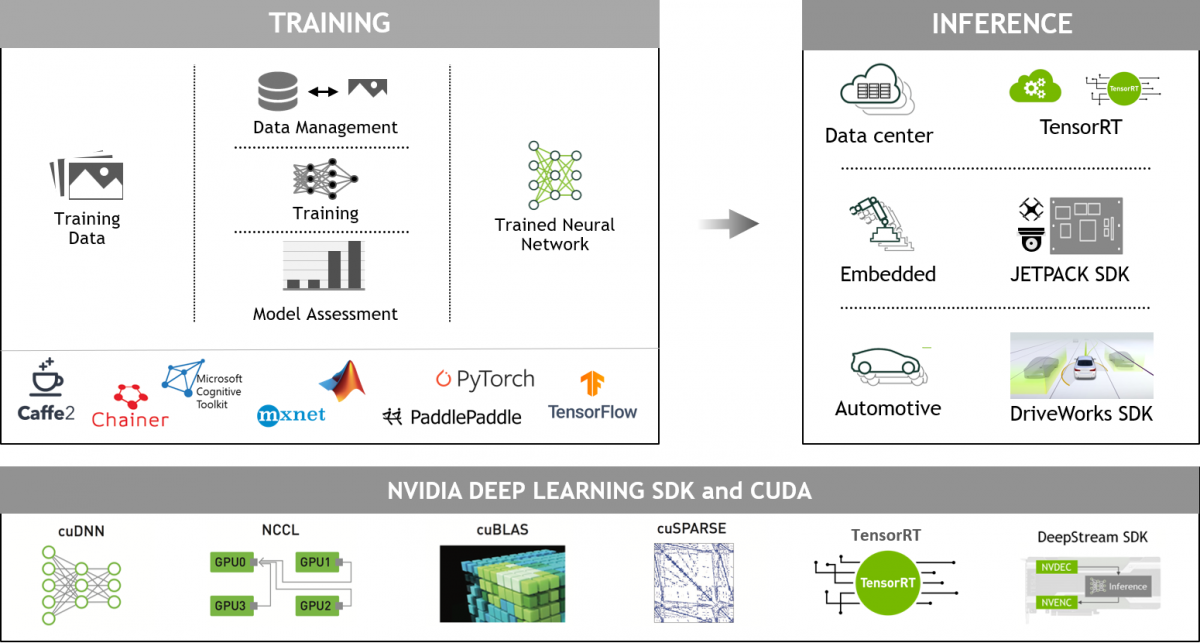

NVIDIA GPU 加速的深度学习框架

GPU 加速深度学习框架能够为设计和训练自定义深度神经网络带来灵活性,并为 Python 和 C/C++ 等常用编程语言提供编程接口。MXNet、PyTorch、TensorFlow 等广泛使用的深度学习框架依赖于 NVIDIA GPU 加速库,能够提供高性能的多 GPU 加速训练。