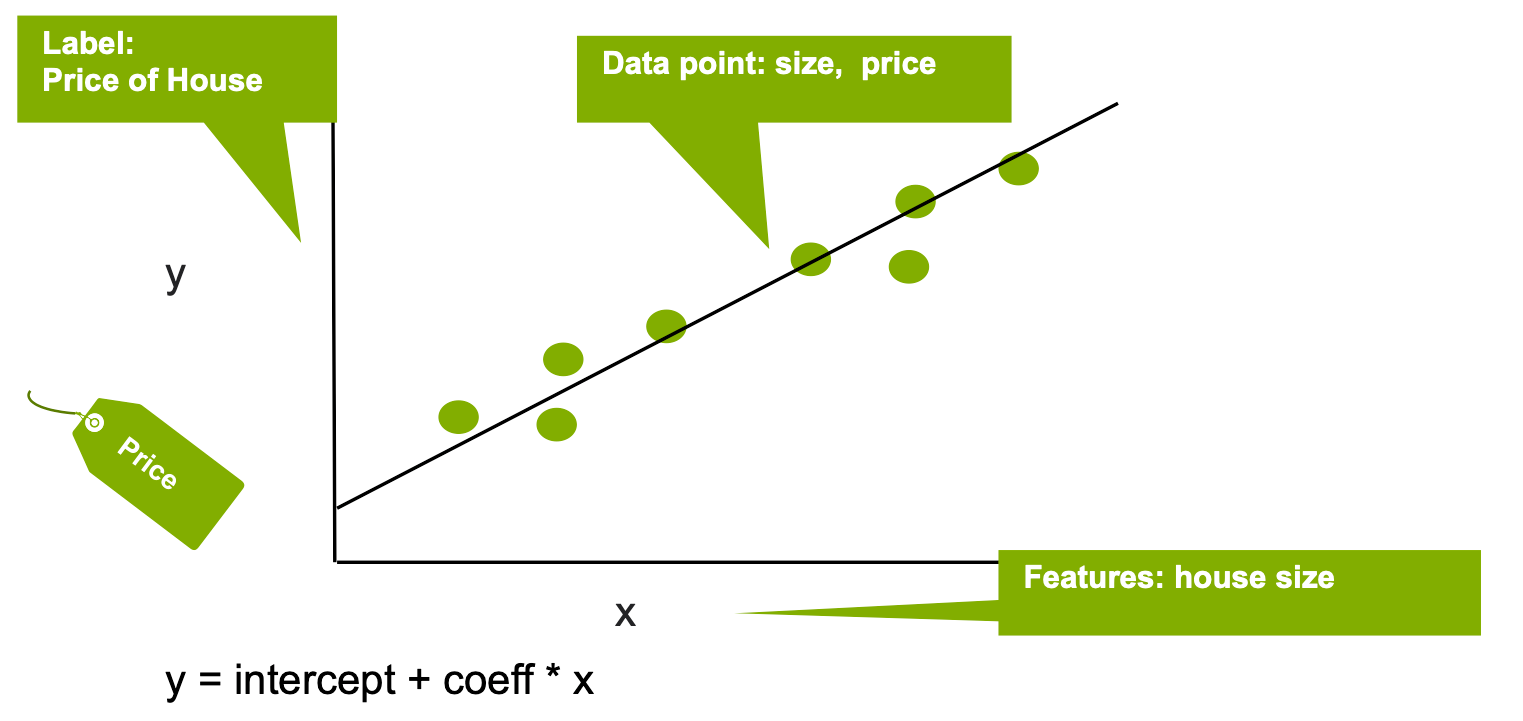

线性回归可通过一组数据点来拟合线性模型,以便估算目标结果标签与一个或多个特征变量之间的关系,从而预测数值。输出值 y(标签)可预测为一条直线,且该直线可用如下表达式表示:

y = 截距 + ci * xi + 误差

其中 xi 为输入变量(特征),参数 ci、截距和误差分别为回归系数、常数偏移量和误差。系数 ci 可解释为因变量(y 标签)随相应自变量(x 特征)的单位增加而增加。在下面的简单示例中,线性回归用于根据房屋面积(x 特征)估算房价(y 标签)。

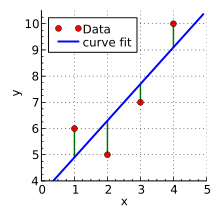

x 和 y 点与线之间的距离决定了自变量与因变量之间的连接强度。曲线斜率通常使用最小二乘法确定,该方法可尽可能降低曲线上点偏移量的平方的总和。

来源:维基百科

线性回归有两种基本类型 – 简单线性回归和多重线性回归。在简单线性回归中,一个自变量用于解释或预测一个因变量的结果。多重线性回归则使用两个或多个自变量来实现此目的。

回归通常用于预测结果。例如,回归可能是用于找出刷牙和蛀牙之间的关联。x 轴是给定群体中蛀牙的频率,而 y 轴是该群体中人刷牙的频率。每个人每周的刷牙频率及其蛀牙数量由图表上的一个点表示。在现实世界中,图表上将到处都是点,因为即使一些人经常刷牙也会出现蛀牙,而有些人即使不刷牙也不会出现蛀牙。但是,根据对蛀牙的已知信息,图表上所有点趋向的线可能会向下和向右倾斜。

回归分析的广泛应用之一是天气。当变量之间可建立强相关性时(例如大西洋东北部的海洋温度与飓风的发生率),我们可创建一个公式,根据自变量的变化预测未来事件。

回归分析还可用于金融场景,例如根据历史利率预测投资账户的未来价值。虽然每个月的利率各不相同,但从长远来看,出现了一些模式,可将其用于以合理的准确度预测增长和投资。

该技术还可用于确定关系不直观的因素之间的相关性。不过,需要牢记的是,相关性和因果关系是两个不同的因素。混淆它们可能会导致危险的误判。例如,冰激凌销量和溺水死亡的频率与第三因素(夏天)相关,但没有理由认为吃冰激凌与溺水有关。

此时,多重线性回归非常有用。它会检查多个自变量,以预测单个因变量的结果。它还假设因变量和自变量之间存在线性关系,残差(位于回归线上方或下方的点)属于法线,并且所有随机变量都有相同的有限方差。

多重线性回归可用于识别自变量影响的相对强度,并衡量任何一组自变量对因变量的影响。它比简单的线性回归更有用,因为问题集存在大量因素,例如预测商品价格。

第三种类型称为非线性回归,其中数据可拟合为模型,并可表示为数学函数。通常涉及多个变量,其关系会表示为曲线而非直线。非线性回归可估计自变量和因变量之间的任意关系模型。一个常见示例是随着时间的推移预测人口。虽然人口与时间之间有着密切的关系,但由于各种因素影响年年变化,因此这一关系并不是线性的。非线性人口增长模型可针对未实际测量的时间对人口做出预测。