NVIDIA NVLink 和 NVLink 交换机

纵向扩展网络实现 GPU 到 GPU 的高带宽通信,助力 AI 训练、推理和其他要求严苛的机架级 GPU 加速工作负载。

速度更快的纵向扩展互连

最新的 AI 模型追求最卓越的性能,需要在整个服务器机架内实现无缝、高吞吐量的 GPU 到 GPU 通信。第六代 NVIDIA NVLink™ 和 NVLink Switch 支持超低延迟、海量网络带宽和全连接,专为加速训练和推理而设计,显著提高推理和代理式 AI 工作负载的性能。

借助 NVIDIA NVLink 技术最大化地提升系统吞吐量和持续运行时间

第六代 NVLink 可为 NVIDIA Rubin 平台的每个 GPU 提供 3.6 TB/s 的带宽,带宽是上一代的 2 倍,是 PCIe Gen6 的 14 倍以上。NVIDIA Vera Rubin NVL72 机架级架构实现 72 个 GPU 的all-to-all 拓扑连接,总带宽达 260 TB/s,为领先的MoE模型架构的训练和推理提供海量的 all-to-all 通信带宽。NVLink 6 交换机还引入了新的管理和高可靠性功能,旨在更大限度地提升系统持续运行时间,包括控制平面高可靠性、使用部分机架资源持续运行的能力,以及对交换机托盘的热插拔。

NVLink 大规模性能

与上一代产品相比,NVIDIA Rubin 中的第六代 NVIDIA NVLink 可将 GPU 到 GPU 的通信带宽提高 2 倍,从而助力最新的 AI 模型架构加快训练和推理速度。

借助 NVLink 通信提高逻辑推理吞吐量

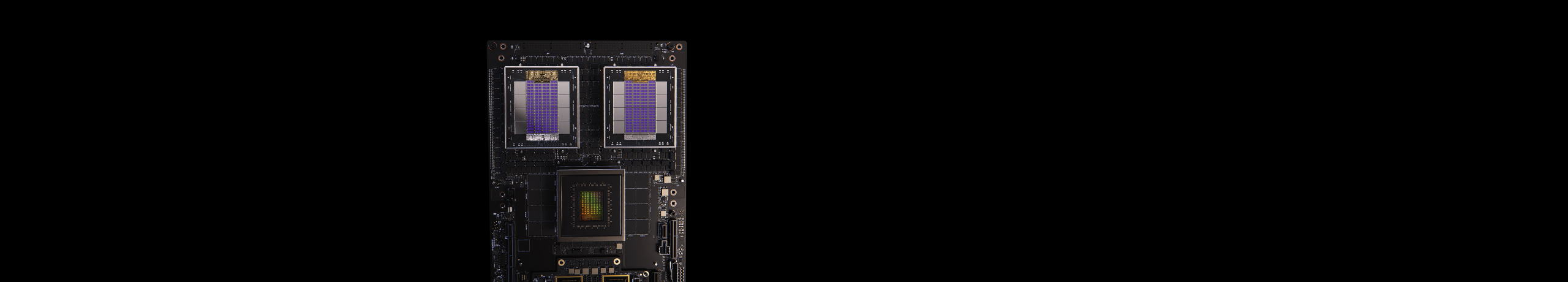

使用 NVIDIA NVLink 和 NVLink 交换机完全连接 GPU

NVLink 是一种 3.6 TB/s 的双向 GPU 到 GPU 直接互连技术,可扩展服务器内的多 GPU 输入和输出 (IO) 。NVIDIA NVLink Switch 芯片可连接多个 NVLink,在整个机架内基于 NVLink 实现全线速 all-to-all GPU 通信。

为了支持高速集合运算,每个 NVLink 交换机都配有 NVIDIA SHARP™ 技术引擎,可用于网络内归约和组播加速。

借助 NVLink 交换机系统加速万亿参数模型的测试时逻辑推理

借助 NVLink Switch,NVLink 连接可以跨节点扩展,创建无缝、高带宽、多节点的 GPU 集群,从而有效地形成数据中心大小的 GPU。NVIDIA NVLink 交换机可在一个 NVIDIA Vera Rubin NVL72 系统中实现 260 TB/s 的 GPU 聚合带宽,从而加速大型模型并行计算。采用 NVLink 的多服务器集群可在计算能力显著增加的情况下平衡 GPU 通信,因此与单个 8 GPU 系统相比,NVIDIA Vera Rubin NVL72 可支持 9 倍的 GPU 数量。

NVIDIA NVLink Fusion

NVIDIA NVLink™ Fusion 为自定义计算提供行业领先的 AI 性能扩展,使超大规模企业能够使用 NVIDIA NVLink 技术和机架级扩展架构构建通用 AI 基础设施。

从企业级计算扩展至百亿亿次级 (Exascale) 计算

通过完全连接实现非凡性能

Vera Rubin NVL72 中的 NVLink Switch 芯片可实现 72 个 GPU 的全连接无阻塞计算网络。NVLink Switch 能以惊人的 3.6 TB/s 速度互连每对 GPU。支持全线速 all-to-all 通信。Vera Rubin NVL72 中的 72 个 GPU 可整体用作单个高性能加速器,支持高达 3.6 exaFLOPS 的 AI 计算能力。

功能强大的 AI 和 HPC 平台

NVLink 和 NVLink 交换机是整个 NVIDIA 数据中心解决方案的必要基础模组,该解决方案融合了来自 NVIDIA AI Enterprise 软件套件和 NVIDIA NGC™ 目录中的硬件、网络、软件、库以及优化的 AI 模型和应用。作为强大的端到端 AI 和高性能计算平台,它让研究人员能够更快地得到真实的结果,并能将解决方案部署到生产环境中,从而在各种规模上实现出色的加速。

规格

-

NVLink

-

NVLink 交换机

| 第四代 | 第五代 | 第六代 | |

|---|---|---|---|

| 每 GPU 的 NVLink 带宽 | 900GB/s | 1,800GB/s | 3,600 GB/s |

| 每 GPU 的最大链路数 | 18 | 18 | 36 |

| 支持的 NVIDIA 架构 | NVIDIA Hopper™ 架构 | NVIDIA Blackwell 架构 | NVIDIA Rubin 平台 |

| NVLink 4 交换机 | NVLink 5 交换机 | NVLink 6 交换机 | |

|---|---|---|---|

| NVLink GPU 域 | 8 | 8 | 72 | 8 | 72 |

| NVLink 交换机 GPU 到 GPU 带宽 | 900 GB/s | 1,800 GB/s | 3,600 GB/s |

| 总聚合带宽 | 7.2 TB/s | 130 TB/s (NVL72) | 260 TB/s (NVL72) |

| 支持的 NVIDIA 架构 | NVIDIA Hopper™ 架构 | NVIDIA Blackwell 架构 | NVIDIA Rubin 平台 |

初步规格,可能会有所变更

深入了解 NVIDIA Rubin 平台。